AGI-Eval是什么?

AGI-Eval,一个由上海交通大学、同济大学、华东师范大学及DataWhale等知名高校与机构强强联合打造的大模型评测社区,正以“评测助力,让AI成为人类更好的伙伴”为使命,致力于构建一个公正、可信、科学且全面的评测生态体系。这一平台专注于评估基础模型在人类认知与问题解决任务中的通用能力,通过一系列精心设计的考试,直接关联并衡量模型与人类决策、认知能力的契合度,进而揭示其在现实生活中的适用性与有效性。

核心功能亮点

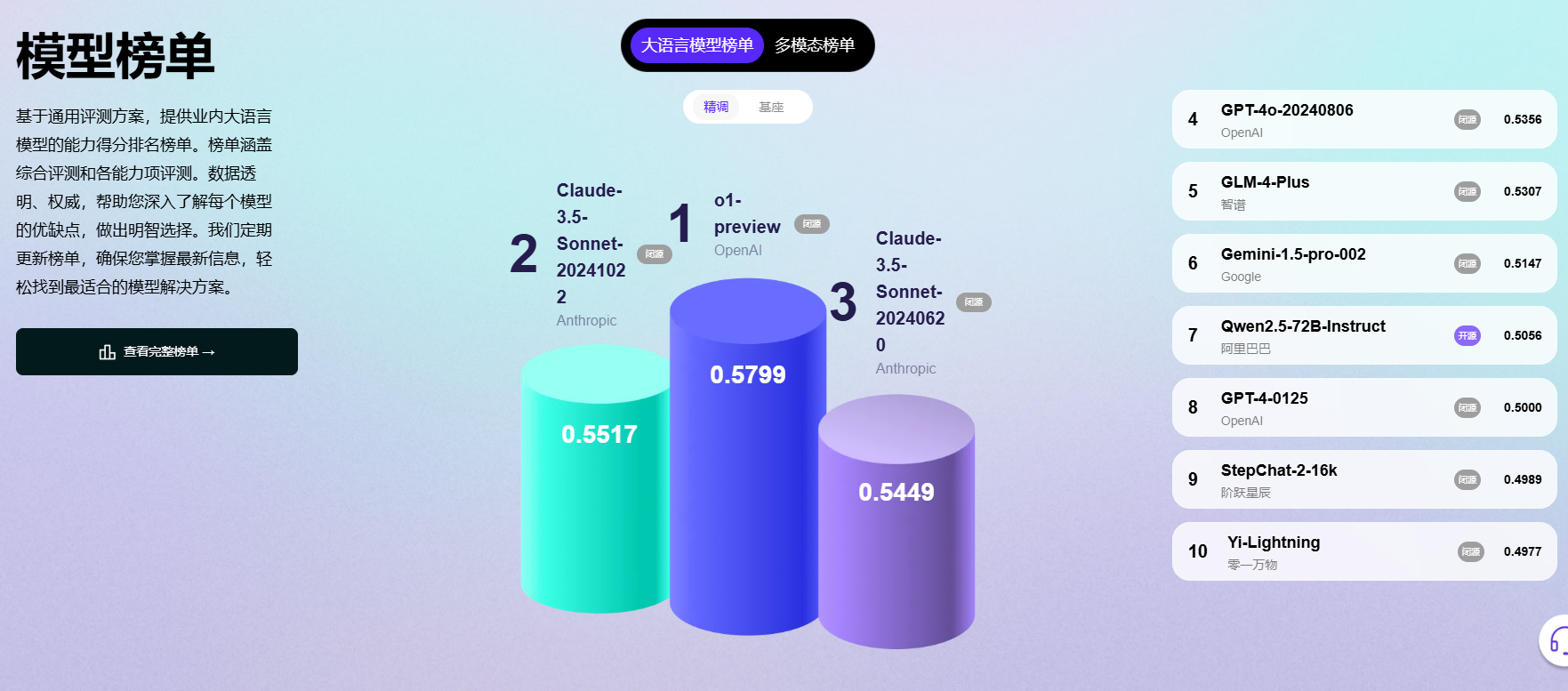

1. 大模型榜单:

- 权威排名:基于统一的评测标准,AGI-Eval提供业内大语言模型的全面能力得分排名,涵盖综合评测及各专项能力评测,数据透明、权威,助您深入洞察每个模型的优劣。

- 动态更新:榜单定期更新,确保您紧跟技术前沿,轻松找到最贴合需求的模型解决方案。

2. 人机评测比赛:

- 深度探索:邀请您深入模型评测的奥秘世界,与大模型携手共进,共同推动技术发展,构建创新的人机协同评测方案。

3. 丰富评测集:

- 公开学术评测集:汇聚行业公开资源,供用户自由下载使用。

- 官方自建评测集:涵盖多领域、多维度模型评测,专业且全面。

- 用户自建评测集:支持用户上传个人评测集,共建开源社区,实现自动与人工评测的完美融合。同时,平台还提供高校大牛私有数据集托管服务,满足更高级别的评测需求。

4. Data Studio数据工坊:

- 高活跃度用户平台:拥有3W+众包用户,确保高质量真实数据的持续回收。

- 数据类型多样化:覆盖多维度、多领域专业数据,满足各类评测需求。

- 数据收集灵活:支持单条数据、扩写数据、Arena数据等多种收集方式,灵活应对不同评测场景。

- 严格审核机制:实施机审+人审双重审核,确保数据质量无忧。

广泛应用场景

- 模型性能评估:AGI-Eval提供完整的数据集、基线系统评估及详尽的评估方法,成为衡量AI模型综合能力的权威工具。

- 语言评估平台:整合中英文双语任务,为AI模型的语言能力提供全面、专业的评估舞台。

- NLP算法开发:开发者可借助AGI-Eval测试并优化文本生成模型,显著提升生成文本的质量与效果。

- 科研实验助手:学者可利用AGI-Eval作为评估新方法性能的得力工具,加速自然语言处理(NLP)领域的研究进程,推动学术创新。

- AGI-Eval,作为AI模型评测领域的佼佼者,正以其专业、全面的评测体系,助力AI技术更加精准地服务于人类社会,成为连接人与AI的桥梁,共同探索智能未来的无限可能。

更多实用AI工具推荐请关注AI人工智能网站–www.aisosuo.cc-AI搜索网

发表评论